怎么把网页的数据导入excel(网页数据导入Excel)

在当今数字化的时代,数据的处理和转换成为了日常工作中的重要环节。而将网页上的数据导入到Excel中,能够更方便地对数据进行整理、分析和存储。那么,到底怎么把网页的数据导入Excel呢?我们将分几个要点来详细阐述。

一、使用Excel自带功能

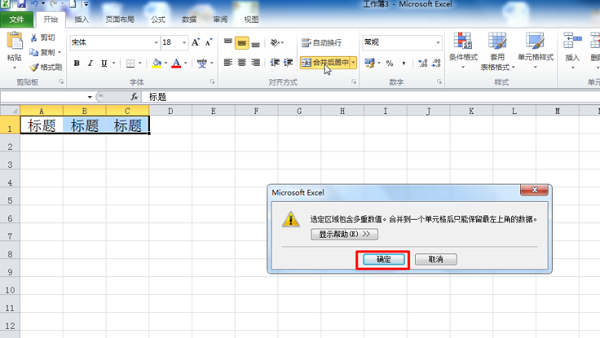

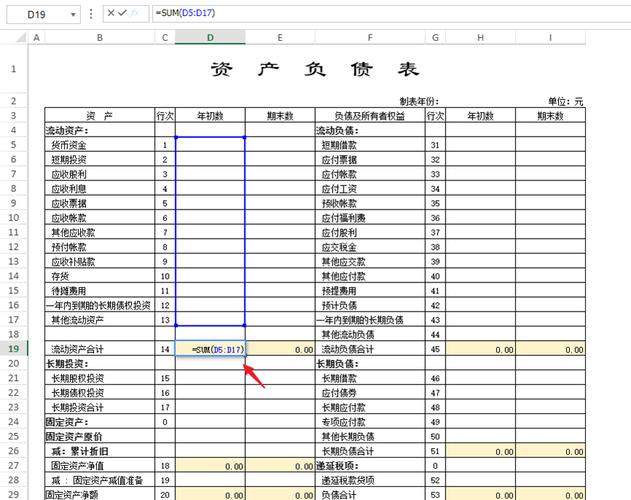

许多网页上的数据都有一定的规律性,比如存在于表格之中。对于这类有规律的表格数据,Excel自身提供了一些简单的方法来获取。例如,当你打开一个包含表格数据的网页时,你可以直接选中表格中的全部或部分数据,通过复制(Ctrl + C)操作,然后切换到Excel工作表,选中要粘贴数据的位置,执行粘贴(Ctrl + V)命令。Excel会自动识别并按照表格的格式将数据粘贴进来,这种方式操作简单快捷,适用于数据量较小且结构简单的情况。假设一个新闻网站上有一份关于某地区一周天气情况的表格,包括日期、天气状况、温度等信息,你就可以用这种复制粘贴的方法快速将其导入Excel,方便后续查看和分析天气数据的变化趋势。

二、借助浏览器插件

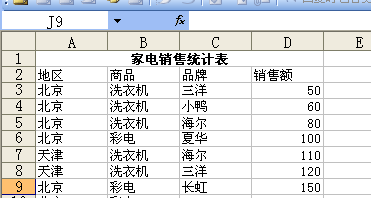

有些浏览器插件能够帮助我们更高效地将网页数据导入Excel。以“Web Scraper”这款浏览器扩展为例,它可以安装在常见的浏览器如Chrome上。安装完成后,当你访问包含想要提取数据的网页时,点击该插件图标,它会提供一系列工具来帮助你定位和抓取网页元素。你可以按照提示选择数据所在的区域,比如特定的表格行或列,设置好抓取规则后,插件就能自动提取出相应的数据并将其整理成适合导入Excel的格式。这对于一些数据结构较为复杂或者需要批量提取数据的网页来说非常实用。例如,在一个电商网站上,如果你想提取多个商品的详细信息如名称、价格、销量等,使用这种插件可以快速准确地完成数据采集,并轻松导入Excel以便进一步进行销售数据分析或库存管理。

三、利用编程语言辅助

对于有一定编程基础的用户,还可以使用编程语言来实现网页数据到Excel的导入。Python是一种非常流行的用于数据处理的语言,其中有很多库可以帮助我们完成这个任务。例如“BeautifulSoup”库可以用来解析网页的HTML结构,提取所需的数据;“pandas”库则可以方便地进行数据处理和转换,并且能够直接将处理好的数据保存为Excel文件。你需要使用相关函数获取网页的HTML代码,然后通过“BeautifulSoup”根据网页元素的标签或属性定位到数据所在位置并将其提取出来,接着利用“pandas”将提取的数据构建成一个数据框,最后调用“to_excel”方法就可以将其保存为Excel文件。这种方法灵活性高,可以处理各种复杂的网页数据情况。比如,对于一个论坛页面上的大量用户发言记录,你可以编写Python脚本来精确提取每条发言的内容、时间、作者等信息,并进行有效的整理和存储在Excel中,以便进行文本分析或舆情监测等工作。

把网页的数据导入Excel有多种不同的方法可供选择。无论是利用Excel自身的简单操作、借助浏览器插件还是采用编程语言辅助,都可以根据具体的网页特点和个人需求来灵活运用。通过掌握这些技巧,我们能够更加高效地处理网页数据,为工作和生活带来更多便利与价值。

本文系作者个人观点,不代表本站立场,转载请注明出处!